AI输出知识图谱数据,通常是需要结构化的数据,目前以JSON格式为主。

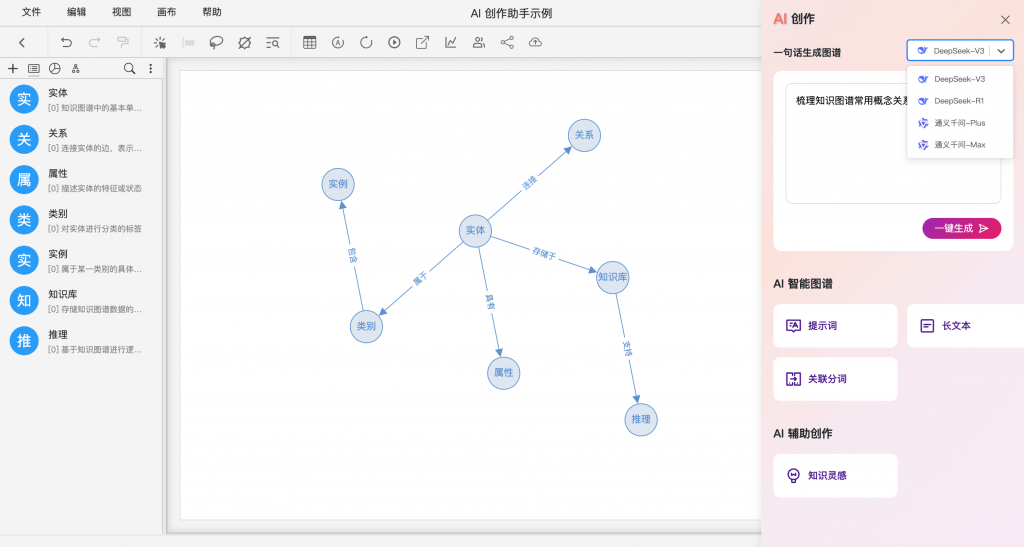

DeepSeek V3模型支持结构化输出,但对硬件要求较高,最小版占用空间超过 400GB,而 DeepSeek R1推理模型不太适合输出结构化数据。

NRD Studio知识图谱软件企业版集成了Ollama,通过配置可以直接调用本地模型服务。

本地用Ollama方式部署大模型,可以考虑使用千问(Qwen)系列,对JSON结构化数据都很成熟,与NRD Studio的兼容性也不错。

在本地部署大模型时,Ollama 是一个便捷的选择。若对以下方面有明确需求,可以优先考虑安装千问(Qwen)系列模型:

1.数据安全与私密性要求高:所有数据处理均在本地完成,避免敏感信息外泄;

2.模型处理能力要求适中:无需追求极致的参数量与推理性能;

3.结构化输出需求强:如构建知识图谱等任务,对输出的完整性、准确性有较高要求。

相比之下,DeepSeek 系列模型在本地部署中存在一定限制:

1.DeepSeek-V3 最低版本需占用超过 400GB 存储空间,完整版对硬件资源的要求更高;

2.DeepSeek-R1 作为推理模型,在生成结构化输出(如 JSON等)方面表现不够稳定,不利于图谱构建等结构化任务。

通义千问在结构化输出方面已较为成熟,能够有效支持如信息抽取、格式规整等任务场景,而且支持更长的上下文。

Ollama跨服务器访问时,需要在设置中打开允许外部连接,如图6。